Lợi dụng Deepfake chiếm đoạt tiền

Mới đây, khi triển khai xác thực sinh trắc học bằng khuôn mặt, các ngân hàng đã phát đi thông báo đến khách hàng để cảnh báo về hình thức lừa đảo mới của các đối tượng lừa đảo trên không gian mạng. Trong đó, hình thức lừa đảo mới nhất là sử dụng công nghệ Deepfake - giả hình ảnh và giọng nói để giả mạo cán bộ cơ quan nhà nước (công an, cơ quan thuế, tòa án…) hoặc người quen của nạn nhân để gọi video call (cuộc gọi trực tiếp bằng hình) với nạn nhân.

Khi gọi video call, kẻ gian bằng các thủ đoạn khác nhau sẽ yêu cầu nạn nhân nhìn thẳng, nhìn sang trái, nhìn sang phải, nhìn lên, nhìn xuống. Đối tượng sẽ ghi lại video và sử dụng để mở tài khoản online (eKYC) tại các tổ chức tài chính - ngân hàng. Trong một số trường hợp, kẻ gian yêu cầu nạn nhân cung cấp thêm các thông tin cá nhân như số CMT/CCCD, số điện thoại, địa chỉ …

Khách hàng vô tình thực hiện theo các yêu cầu này đã gián tiếp giúp đối tượng có dữ liệu để đăng ký mở tài khoản thành công. Cuối cùng, kẻ gian sẽ sử dụng các tài khoản này với mục đích xấu.

Trước đó, vào đầu tháng 6, nhiều ngân hàng khác cũng đã phát đi thông báo khuyến cáo người dùng nâng cao cảnh giác với các đối tượng lừa đảo sử dụng tài khoản mạng xã hội (Zalo, Facebook...) hoặc tạo tài khoản mạng xã hội giả danh người thân của nạn nhân, sau đó các đối tượng này thu thập thông tin cá nhân, hình ảnh, video có giọng nói có sẵn và sử dụng công nghệ Deepfake để tạo ra các video giả mạo.

Từ đó, các đối sử dụng tài khoản mạng xã hội giả mạo hoặc chiếm đoạt được để nhắn tin mượn tiền hay nhờ chuyển tiền hoặc thông báo người thân của nạn nhân gặp nguy hiểm nhằm yêu cầu chuyển tiền gấp…; đồng thời thực hiện cuộc gọi video mạo danh, phát video giả nhằm xác thực thông tin, tăng độ tin cậy để lừa nạn nhân chuyển tiền.

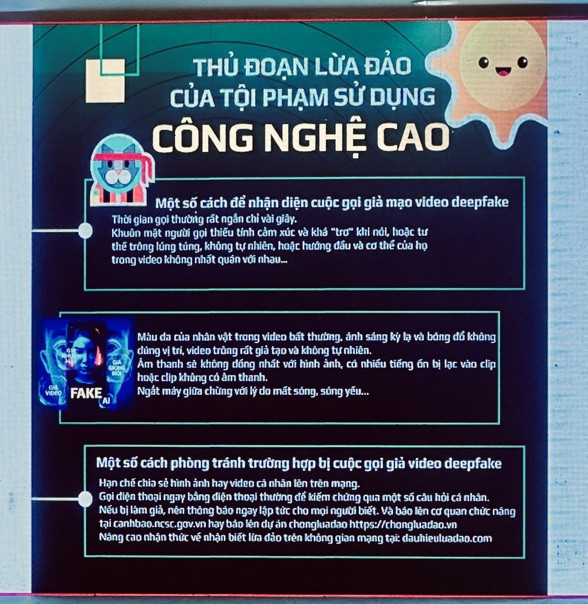

Nhận diện các dấu hiệu lừa đảo sử dụng công nghệ Deepfake AI

Trước những cảnh báo được nêu ra, ông Võ Đỗ Thắng, Giám đốc Trung tâm tư vấn và Đào tạo An ninh mạng ATHENA cũng đưa ra các phân tích về dấu hiệu nhận biết các cuộc gọi sử dụng công nghệ Deepfake. Theo ông Thắng, đó là các cuộc gọi giả mạo thường có hình ảnh của nạn nhân, tuy nhiên âm thanh, hình ảnh không rõ nét, tín hiệu chập chờn, thời lượng ngắn; sau đó đối tượng lấy lý do mạng chập chờn, mất sóng, đường truyền kém để dừng cuộc gọi video.

"Dấu hiệu khác để nhận diện cuộc gọi mạo danh này, nội dung trả lời không trực tiếp vào câu hỏi của người nhận cuộc gọi lừa đảo hoặc không phù hợp với ngữ cảnh đang giao tiếp" - ông Thắng nói.

Theo đó, ông Thắng khuyến cáo người dân hạn chế chia sẻ hình ảnh, video có giọng nói thật, thông tin cá nhân trên mạng xã hội. Nâng cao cảnh giác với các tin nhắn, cuộc gọi hỏi vay mượn tiền, yêu cầu chuyển tiền, kể cả xác nhận qua video nếu có dấu hiệu nghi ngờ. Chú ý kiểm tra kỹ thông tin tài khoản nhận tiền bằng cách gọi điện trực tiếp vào số điện thoại của người liên hệ (không gọi qua các ứng dụng miễn phí) để xác minh lại thông tin trước khi chuyển tiền.

Cùng với đó, ông Thắng cũng đưa ra lời khuyên cho các ngân hàng. Cụ thể, để ngăn chặn nguy cơ bị lừa đảo và bảo vệ quyền lợi của khách hàng, các ngân hàng khuyến cáo người dùng nên nâng cao cảnh giác với các cuộc gọi giới thiệu là nhân viên của cơ quan nhà nước hoặc người quen, đặc biệt với các yêu cầu thực hiện các hành động lạ như: nhìn thẳng, nhìn sang trái, nhìn lên, nhìn xuống.

Hướng dẫn cách tránh bẫy lừa đảo bằng Deepfake

Theo ông Võ Đỗ Thắng, công nghệ lừa đảo sử dụng công nghệ Deepfake rất nguy hiểm, tuy nhiên có những cách để người dùng nhận biết video sử dụng công nghệ ứng dụng trí tuệ nhân tạo này, từ đó tránh bị các đối tượng xấu lừa.

"Các đối tượng lừa đảo sử dụng deepfake AI thường xây dựng những kịch bản giả mạo rất đời thực như con cái đi du học nước ngoài, người thân bị tai nạn cần cấp cứu gấp…Khi đó, các đối tượng lừa đảo sử dụng công nghệ Deepfake (công nghệ ứng dụng trí tuệ nhân tạo - AI tạo ra các sản phẩm công nghệ âm thanh, hình ảnh và video làm giả đối tượng ngoài đời thực với độ chính xác rất cao) để thực hiện cuộc gọi video giả mạo người thân vay tiền, giả làm con cái đang du học nước ngoài gọi điện cho bố mẹ nhờ chuyển tiền đóng học phí hay có thể giả tạo ra những tình huống khẩn cấp như người thân bị tai nạn cần tiền gấp để cấp cứu…" - ông Võ Đỗ Thắng nói.

Ông Võ Đỗ Thắng cũng khẳng định, hiện nay, trên không gian mạng đang có nhiều công cụ hỗ trợ các đối tượng tạo ra các video Deepfake. Chỉ cần có 1 tấm hình nạn nhân thì các công cụ Deepfake AI có thể sản xuất ra video, có nạn nhân đang trao đổi hay trình bày một vấn đề gì đó giống như thật , khiến nhiều người lâu nay rất khó bị lừa cũng trở thành nạn nhân bị lừa. Những người tầm trung niên trở lên là đối tượng dễ bị lừa nhất vì họ thiếu nhận thức về an toàn thông tin, công nghệ và khó nhận biết kiểu lừa đảo tinh vi này.

Tuy nhiên, để tránh bẫy lừa đảo bởi các clip giả mạo được sản xuất bằng công nghệ Deepfake AI, theo Võ Đỗ Thắng, mọi người khi tiếp cận những cuộc gọi video thì cần phải xác minh lại thông tin từ người gọi. Do đó, mọi người thay vì thụ động tiếp nhận các video, người dân chỉ cần tắt điện thoại và thực hiện gọi ngược lại, và đặt ra những câu hỏi, hỏi ngược lại với người gọi video.

Nếu người gọi là người quen biết, thì người gọi sẽ ra lời các câu hỏi đúng nội dung, đúng trọng tâm. Còn trong trường hợp, cuộc gọi video do Deepfake AI tạo nên, thì khi người dân gọi ngược lại, kẻ lừa đảo dùng Deepfake thông thường không dám bắt máy, hoặc trả lời câu hỏi lan man, không đúng nội dung,…Như vậy, khi đó có thể kết luận đó là những video lừa đảo bằng Deepfake.

Ông Thắng chia sẻ thêm, với các làm trên, chỉ cần tắt máy và gọi video ngược lại mà bất kỳ ai cũng làm được. Cách làm này Trung tâm Tư vấn và đào tạo an ninh mạng ATHENA đã tư vấn và hướng dẫn cho nhiều người và kết quả đạt được rất tích cực, giúp rất nhiều người dân không bị sập bẫy lừa đảo bởi những video do kẻ lừa đảo dùng Deepfake AI tạo ra.